Odtwarzalność: Tragedia błędów

Błędy w recenzowanych artykułach są łatwe do znalezienia, ale trudne do naprawienia, donoszą David B. Allison i współpracownicy.

Źródło: Nature. 2016 Feb 4;530(7588):27-9; Reproducibility: A tragedy of errors https://pubmed.ncbi.nlm.nih.gov/26842041/

Jak podatna na błędy i samokorygująca się jest nauka? Spędziliśmy ostatnie 18 miesięcy, aby to zrozumieć.

Jesteśmy grupą badaczy zajmujących się otyłością, odżywianiem i energetyką. Latem 2014 r. jeden z nas (David B. Allison) przeczytał artykuł badawczy w renomowanym czasopiśmie, w którym oszacowano, w jaki sposób zmiana w konsumpcji fast-foodów wpłynie na wagę dzieci, i zauważył, że w analizie zastosowano model matematyczny, który przeszacował efekty ponad dziesięciokrotnie. Wraz z innymi wysłaliśmy do redakcji list[1] wyjaśniający ten problem. Miesiące później z satysfakcją dowiedzieliśmy się, że autorzy zdecydowali się wycofać swój artykuł. W obliczu popularnych artykułów głoszących, że nauka się potyka, ten epizod był potwierdzeniem, że nauka jest samonaprawiająca się.

Niestety, z naszego doświadczenia wynika, że przypadek ten nie jest reprezentatywny. W trakcie gromadzenia cotygodniowych list artykułów z naszej dziedziny zaczęliśmy zauważać więcej recenzowanych artykułów zawierających coś, co nazywamy błędami merytorycznymi lub unieważniającymi. Obejmują one błędy rzeczowe lub znacznie odbiegają od jasno przyjętych procedur w sposób, który, jeśli zostanie poprawiony, może zmienić wnioski artykułu.

Po próbie usunięcia ponad 25 z tych błędów za pomocą listów do autorów lub czasopism i zidentyfikowaniu co najmniej tuzina innych, musieliśmy przestać – praca pochłaniała zbyt dużo naszego czasu. Nasze wysiłki ujawniły powtarzające się praktyki unieważniające (patrz „Trzy powszechne błędy”) i pokazały, jak czasopisma i autorzy reagują w obliczu błędów, które wymagają korekty.

Trzy powszechne błędy

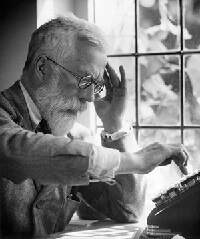

Jak powiedział wpływowy dwudziestowieczny statystyk Ronald Fisher (na zdjęciu): „Konsultowanie się ze statystykiem po zakończeniu eksperymentu jest często jedynie proszeniem go o przeprowadzenie sekcji zwłok. Może on powiedzieć, na co eksperyment umarł”.

Zbyt wiele z naszych recenzji po publikacji było rzeczywiście sekcjami zwłok. Niektóre badania wykorzystywały nieodpowiednie lub nierandomizowane metody, pomimo stwierdzenia, że ich badania były randomizowane (patrz na przykład ref. 5 i go.nature.com/x2l9zz). Inne opisywały matematycznie lub fizjologicznie niemożliwe wyniki: wartości p większe niż 1 lub średnią zmianę wzrostu o około 7 centymetrów u dorosłych w ciągu 8 tygodni[4,6].

Częste błędy, po ich rozpoznaniu, można wyeliminować z literatury dzięki ukierunkowanej edukacji i polityce. Poniżej przedstawiono trzy z najczęstszych. Te i inne zostały szczegółowo opisane w nadchodzącej publikacji[7].

1.Błędny projekt lub analiza badań z randomizacją klastrową. W badaniach tych wszyscy uczestnicy klastra (na przykład klatki, szkoły lub szpitala) są poddawani takiemu samemu leczeniu. W analizie należy uwzględnić liczbę klastrów (a nie tylko liczbę osobników). W przeciwnym razie wyniki często wydają się fałszywie istotne statystycznie[8,9]. Zwiększenie liczby osobników w klastrach może zwiększyć moc, ale korzyści są niewielkie w porównaniu ze zwiększeniem liczby klastrów. Projekty z tylko jednym klastrem na leczenie nie są ważne jako randomizowane eksperymenty, niezależnie od liczby osób.

2.Błędne obliczenia w metaanalizach. Wielkości efektów są często błędnie obliczane, gdy metaanalitycy mają do czynienia z niekompletnymi informacjami i nie dostosowują się do nich w odpowiedni sposób. Innym problemem jest niejasność co do sposobu obliczania wariancji efektów. Różne projekty badań i metaanalizy wymagają różnych podejść. Nieprawidłowe lub niespójne wybory mogą zmienić wielkość efektu, wagę badania lub ogólne wnioski[4].

3.Niewłaściwe porównania wyjściowe. W co najmniej sześciu artykułach autorzy testowali zmiany w stosunku do wartości wyjściowej w oddzielnych grupach; jeśli jedna była znacząca, a druga nie, autorzy (błędnie) proponowali różnicę między grupami. Zamiast porównywać „różnice w istotności nominalnej” (błąd DINS), różnice między grupami muszą być porównywane bezpośrednio. W przypadku badań porównujących dwie grupy o równej wielkości, błąd DINS może zawyżyć wskaźnik wyników fałszywie dodatnich z 5% do nawet 50% (ref. 10).

Dowiedzieliśmy się, że wzajemna weryfikacja [recenzowanie] po publikacji nie jest spójna, płynna ani szybka. Wielu redaktorów i pracowników czasopism wydawało się nieprzygotowanych lub źle przygotowanych do zbadania sprawy, podjęcia działań lub nawet zareagowania. Zbyt często, proces ten przechodził przez kolejne warstwy nieskutecznych e-maili pomiędzy autorami, redaktorami i niezidentyfikowanymi przedstawicielami czasopism, często bez żadnego publicznego oświadczenia dodanego do oryginalnego artykułu. Niektóre czasopisma, które przyznały się do błędów, wymagały od nas uiszczenia znacznej opłaty za publikację naszych listów: proszono nas, byśmy wydali nasze pieniądze na poprawianie cudzych błędów.

Jako pracownicy naukowi, którzy publikują, recenzują artykuły lub pełnią funkcję redaktorów, zdajemy sobie sprawę, że kwestie te są skomplikowane. Uważamy, że redaktorzy czasopism są oddani i szczerzy w swoich wysiłkach. Niemniej jednak społeczność naukowa musi się poprawić.

Nauka opiera się zasadniczo na autokorekcie, ale publikowanie naukowe poważnie zniechęca do takiej korekty. Jeden z wydawców twierdzi, że obciąży autora, który zainicjuje wycofanie opublikowanego artykułu, kwotą 10.000 dolarów.

Poniżej podsumowujemy nasze doświadczenia, główne napotkane bariery i nasze przemyślenia na temat tego, jak uczynić publikowaną naukę bardziej rygorystyczną. (Szczegóły dotyczące innych rozwiązanych kwestii są dostępne na życzenie).

Sześć problemów

Redaktorzy często nie są w stanie lub niechętnie podejmują szybkie i odpowiednie działania. W przypadku jednego artykułu uzyskaliśmy surowe dane zdeponowane online, otrzymaliśmy zgodę instytucji na ponowną analizę danych i przesłaliśmy list do redakcji (za pośrednictwem systemu składania manuskryptów) opisujący potrzebę korekty w ciągu dwóch tygodni. Po dziewięciu miesiącach zwróciliśmy się do czasopisma z pytaniem, dlaczego przynajmniej nie opublikowano wyrażenia zaniepokojenia. Redaktor przyznał, że nie spodziewał się, że proces ten potrwa tak długo. Czasopismo poinformowało o swojej decyzji o przyjęciu naszego listu i wycofaniu artykułu 11 miesięcy po jego złożeniu. List i wycofanie nie zostały jeszcze opublikowane.

Nie jest jasne, gdzie należy wysyłać swoje obawy. Czasopisma rzadko podają, z kim należy się kontaktować w sprawie potencjalnie unieważniających błędów. Musieliśmy zgadywać, czy wysłać list do pracownika lub redaktora, formalnie przesłać list jako manuskrypt, czy skontaktować się bezpośrednio z autorami artykułu. W kilku przypadkach zdecydowaliśmy się skontaktować z autorami, gdy pozorny błąd unieważniający mógł być jedynie niejednoznacznym opisem. W jednoznacznych przypadkach zazwyczaj kontaktowaliśmy się z czasopismem. Często czasopisma nie zapewniały możliwości bezpośredniego kontaktu z redaktorami, a personel redakcyjny korespondował bez identyfikacji; nie byliśmy pewni, czy redaktorzy byli zaangażowani.

Czasopisma, które uznały błędy unieważniające, niechętnie wydawały wycofania. W jednym przypadku my i inni stwierdziliśmy, że artykuł błędnie argumentował, że korekta statystyczna wprowadziła stronniczość, i przesłaliśmy list do redakcji za pośrednictwem systemu składania wniosków czasopisma[2]. Zewnętrzny przegląd statystyczny zlecony następnie przez czasopismo potwierdził błąd. Autorzy zostali poproszeni o wycofanie artykułu, ale odmówili. Ostatecznie czasopismo opublikowało odpowiedź autorów na nasz list oraz podsumowanie krytyki zleconej przez recenzentów. W towarzyszącym artykule redakcyjnym[3] opublikowanym przez czasopismo stwierdzono, że „obowiązkiem każdego autora jest upewnienie się, że procedury statystyczne są prawidłowo stosowane i ważne dla przedłożonego badania”.

Autorzy i czasopisma powinni szybko udostępniać dane i kody w przypadku pojawienia się pytań.

Czasopisma pobierają od autorów opłaty za poprawianie błędów innych. W przypadku jednego artykułu, który naszym zdaniem zawierał błąd unieważniający, mogliśmy opublikować komentarz w internetowym systemie komentowania lub zapłacić „obniżoną” opłatę za zgłoszenie w wysokości 1716 dolarów. W innym czasopiśmie tego samego wydawcy opłata za publikację listu wynosiła 1470 funtów (2100 $). W pismach z czasopisma poinformowano, że „nie jesteśmy w stanie wziąć pod uwagę względów redakcyjnych przy ocenie wniosków o zwolnienie, a jedynie udokumentowaną zdolność autora do zapłaty„. Komisja ds. Etyki Publikacyjnej, niezależny organ, który doradza, jak radzić sobie z niewłaściwym postępowaniem badawczym, twierdzi, że czytelnicy nie powinni być zmuszani do płacenia za czytanie wycofań. Zgodnie z naszą wiedzą, żaden organ nie dyskutował na temat tego, czy osoby trzecie powinny być obciążane kosztami poprawiania błędów.

Nie istnieje standardowy mechanizm żądania surowych danych. Kiedy byliśmy w stanie uzyskać dostęp do danych online, mogliśmy szybko potwierdzić podejrzewane błędy. W co najmniej dwóch przypadkach zażądaliśmy danych od autorów, ale zamiast tego otrzymaliśmy podsumowania obliczeń. Czasami nie otrzymywaliśmy żadnych danych, w którym to momencie nie było jasne, czy pracownicy czasopisma powinni wkroczyć do akcji. Jedno czasopismo wycofało artykuł, gdy jego autorzy odmówili pokazania swoich danych lub wyjaśnienia rozbieżności, które zidentyfikowaliśmy i o których powiadomiliśmy czasopismo w liście[4].

Bezpośrednia współpraca z autorami może opóźnić korektę. Po tym, jak skontaktowaliśmy się z autorami w sprawie innego artykułu, zaproponowali oni ponowną analizę danych, aby rozwiać nasze obawy. Po miesiącu bez odpowiedzi przesłaliśmy do czasopisma list wyrażający zaniepokojenie. List został zrecenzowany i zaakceptowany w ciągu trzech tygodni. Autorzy, gdy zostali poinformowani o oczekującej publikacji naszego listu, wysłali nam e-mail z informacją, że przygotują odpowiedź, a my poprosiliśmy czasopismo, aby nie publikowało naszego listu, abyśmy mogli współpracować z oryginalnymi autorami. Proces ten trwa nadal, dziesięć miesięcy po tym, jak zidentyfikowaliśmy błąd.

Nieformalne wyrażanie obaw jest pomijane. Chociaż platformy internetowe, takie jak PubMed Commons, oferują wygodny sposób komentowania opublikowanych artykułów, nie obejmują one roli pośredniczącej dla redaktorów czasopism, a komentarze nie są włączane do literatury. Publikowane uwagi rzadko są widoczne na stronach internetowych czasopism i nie są powiązane w żaden użyteczny sposób. W rezultacie czytelnicy mogą założyć, że wadliwy artykuł jest poprawny, potencjalnie prowadząc do błędnych decyzji w nauce, opiece nad pacjentem i polityce publicznej.

W jednym przypadku zdecydowaliśmy się opublikować komentarz na stronie internetowej czasopisma i PubMed Commons po miesiącach prywatnej korespondencji, w której autorzy udostępnili dodatkowe dane i powiedzieli, że przygotowują pełną odpowiedź. Obawy zostały potwierdzone, ale pozostały nierozwiązane 15 miesięcy po skontaktowaniu się z autorami i czasopismem oraz 6 miesięcy po opublikowaniu naszego komentarza (patrz go.nature.com/fv8tr2).

Co można zrobić?

Czasopisma mają wytyczne dotyczące przesyłania artykułów i recenzji. Komitet ds. Etyki Publikacji (Committee on Publication Ethics) przedstawił zalecenia dla czasopism dotyczące rozwiązywania problemów w obszarach takich jak autorstwo i recenzowanie. Niewiele jest jednak formalnych wytycznych dotyczących poprawek po publikacji. (Aby zapoznać się z naszymi zaleceniami, zobacz „Naprawianie recenzji po publikacji„).

Czasopisma, wydawcy i towarzystwa naukowe powinny standaryzować, usprawniać i upubliczniać te procesy. Autorzy i czasopisma powinny szybko udostępniać dane i kod w przypadku pojawienia się pytań. Badacze mogą wspomóc ten proces poprzez dostęp do specjalistycznej wiedzy statystycznej w zakresie projektowania i analizy eksperymentów.

Idealnie byłoby, gdyby każdy, kto wykryje potencjalny problem w badaniu, zaangażował się w nie, czy to pisząc do autorów i redaktorów, czy komentując online, i zrobił to w sposób koleżeński. Naukowcy, którzy angażują się w recenzje po publikacji, często robią to z poczucia obowiązku wobec swojej społeczności, ale ta ważna praca nie ma takiego samego prestiżu jak inne przedsięwzięcia naukowe. Uznanie i zachęcanie do takich działań mogłoby znacznie przyczynić się do uporządkowania literatury.

Nasza praca nie była systematycznym wyszukiwaniem; po prostu przyjrzeliśmy się bliżej artykułom, które wpadły nam w oko i które byliśmy gotowi ocenić. Nie znamy odsetka błędów ani motywacji stojących za nimi (to znaczy, czy są to uczciwe błędy, czy „sztuczki statystyczne”). Pokazaliśmy jednak, że niewielki zespół badaczy z doświadczeniem w statystyce i projektowaniu eksperymentów może znaleźć dziesiątki problematycznych artykułów, będąc na bieżąco z literaturą. Większość z nich została wykryta po prostu po przeczytaniu artykułu.

Bardziej formalne badanie pomogłoby ustalić, czy nasze doświadczenia odzwierciedlają [oficjalnie publikowaną] naukę w ogóle i czy nasze zalecenia są wykonalne lub skuteczne. Inni pracujący nad poprawą dokumentacji naukowej napotkali podobne wyzwania. Ben Goldacre, lekarz i działacz, który prowadzi COMPare, projekt sprawdzający, czy wyniki badań klinicznych są zgodne z deklaracjami, powiedział Retraction Watch: „To fenomenalnie pracochłonny proces. Nie ma tygodnia, byśmy nie przeklinali dnia, w którym postanowiliśmy to zrobić”.

Solidna nauka wymaga solidnych poprawek. Nadszedł czas, aby uczynić ten proces mniej uciążliwym.

Bibliografia:

1. Brown, A. W. et al. Child. Obes. 10, 542–545 (2014).

2. Li, P. et al. Obes. Facts 8, 127–129 (2015).

3. Hauner, H. Obes. Facts 8, 125–126 (2015)

4. George, B. J., Brown, A. W. & Allison, D. B. J. Paramedical Sci. 6, 153–154 (2015).

5. George, B. J., Goldsby, T. U., Brown, A. W., Li, P. & Allison, D. B. Int. J. Yoga 9, 87–88 (2016).

6. Thomas, D. M. et al. World J. Acupunct. Moxibustion 25, 66–67 (2015).

7. George, B. J. et al. Obesity (in the press).

8. Brown, A. W. et al. Am. J. Clin. Nutr. 102, 241–248 (2015).

9. Obesity 23, 2522 (2015).

10. Bland, J. M. & Altman, D. G. Am. J. Clin. Nutr. 102, 991–994 (2015).

Zobacz na: O stronniczości badań i publikacji finansowanych przez przemysł farmaceutyczny

To nie odpowiedzi są stronnicze, tylko pytania – efekt finansowania – prof. David Michaels

Imitacja Nauki – Sharyl Attkisson – fałszywe badania naukowe

Jonathan Pageau: Zaufaj nauce – błąd ślepego ‘kierowania się nauką’

Kwestionujesz Naukę™? To do Gułagu! – Ron Paul

Nauka™: religia, której nie wolno kwestionować – Henry Gee

Ponad 30 000 opublikowanych badań może być błędne z powodu zanieczyszczonych komórek – Peter Dockrill

Błąd w oprogramowaniu aparatury FMRI może skutkować podważeniem 15 lat badań nad mózgiem

60 proc. badań klinicznych w Polsce i UE zawiera nieprawdziwe dane

Wytyczne Dotyczące Przedklinicznych Badań Farmakologicznych i Toksykologicznych Szczepionek – EMA

Czy na pewno szczepionki to najlepiej przebadane produkty firm farmaceutycznych? Sprawdźmy.

„Szacuje się, że tylko od 10 do 20 % wszystkich procedur medycznych, obecnie stosowanych w praktykach lekarskich, okazało się skuteczne w badaniach z grupą kontrolną.” – Dr Kerr L. White, Assessing the Efficacy and Safety of Medical Technologies. Sierpień 1978. Office of Technology Assessment (OTA) https://www.princeton.edu/~ota/disk3/1978/7805/780503.PDF

„Tylko około 15% interwencji medycznych jest poparte solidnymi dowodami… Po części dlatego, bo tylko 1% artykułów w czasopismach medycznych jest faktycznie naukowych i częściowo dlatego, bo wiele kuracji w ogóle nie zostało sprawdzonych.” – Where is the wisdom…? Dr Richard Smith, Redaktor, BMJ. 1991 Oct 5; 303(6806): 798–799. https://www.ncbi.nlm.nih.gov/pmc/articles/PMC1671173/

„Zakażenia szpitalne związane z udzielaniem świadczeń zdrowotnych stanowią poważny problem wszystkich szpitali, nawet w krajach o najwyższych standardach opieki zdrowotnej. Dotyczą od 5 do 10 proc. osób leczonych szpitalnie. Zakładając, że w polskich szpitalach ulega zakażeniom tylko 5% pacjentów to i tak daje to około 400 tysięcy osób.” – Brudne ręce lekarzy i pielęgniarek. Zakażają nas w szpitalach, 17.05.2018 http://www.medonet.pl/zdrowie,zakazenia-w-szpitalach-powaznym-problemem–raport-nik,artykul,1725333.html

“W niedawnych badaniach oszacowano, że w USA liczba zgonów z powodu błędów medycznych wynosi około 251.000 rocznie, co sprawia, że błędy medyczne to trzecia najczęstsza przyczyna śmierci. Występowanie błędów jest znacznie wyższe w Stanach Zjednoczonych niż w innych krajach rozwiniętych, takich jak Kanada, Australia, Nowa Zelandia, Niemcy czy Zjednoczone Królestwo (U.K). W tym samym czasie odnotowano mniej niż 10 procent błędów medycznych. W tym badaniu opisano wyniki badania skuteczności wdrożenia systemu raportowania błędów medycznych o nazwie MEDMARX w 25 szpitalach w stanie Pensylwania.” – Źródło: Your Health Care May Kill You: Medical Errors. https://www.ncbi.nlm.nih.gov/m/pubmed/28186008/

http://www.politykazdrowotna.com/9339,bledy-medyczne-3-przyczyna-zgonow-w-usa