Project Veritas, Jen Gennai z Google i Maszynowe Uczenie Sprawiedliwości

Project Veritas, Jen Gennai z Google i Maszynowe Uczenie Sprawiedliwości

Project Veritas. Zdobądź się na odwagę. Działaj.

Wywiad: Zach Vorhies – Informator z Google – Del Bigtree

Zach Vorhies (Informator z google): Powód, dla którego zdecydowałem się skontaktować się z Project Veritas, jest taki, że ludziom należy się wiedza o tym, co tak naprawdę robi Google, że to co widzimy, to tylko fasada. To co się dzieje wewnątrz Google, to, czym naprawdę się zajmują z perspektywy pracownika, to zupełnie coś innego.

„Powodem, dla którego wystartowaliśmy z projektem zasad dla sztucznej inteligencji [S.I.] jest to, że ludzie sami nie nakreślili tych granic. Nie określono, jak mamy rozumieć godziwość/sprawiedliwość i równość, wiec pomyśleliśmy, że skoro jesteśmy dużą firmą, to my to doprecyzujemy.”

„Osoby, które głosowały na obecnego prezydenta nie zgadzają się z naszą definicją godziwości/bezstronności.” – Jen Gennai, Dyr. ds. Odpowiedzialnej Innowacyjności w Google

Zach Vorhies (Informator z google): Oni nie są obiektywnym źródłem informacji.

Gaurav Gite, inżynier oprogramowania w Google: „Jednakże mamy też takie zagadnienia jak ML fairness (wprowadzenie do algorytmów Maszynowego Uczenia Sprawiedliwości)”. –

Dziennikarka: Maszynowe Uczenie Sprawiedliwości?

Gaurav Gite: „Uczciwość. Rozumiesz, konieczność bycia uczciwym, bezstronnym.”

„Uczymy również nasze algorytmy na ewentualność powtórki z 2016 r. testując, czy teraz wynik byłby inny”. – Jen Gennai

Zach Vorhies (Informator z google): Oni są mocno stronniczą maszynerią polityczną, zaangażowaną w niedopuszczenie osób takich jak Donald Trump ponownie do władzy.

„Na 2020 r., na pewno najlepsi ludzie z mojej dawnej organizacji, Trust and Safety [Zaufanie i Bezpieczeństwo], już od 2016 roku pracują intensywnie, byśmy byli w pełni gotowi na 2020 rok” – Jen Gennai

Zach Vorhies: To jest Goliat, a ja jestem tylko skromnym Dawidem. Staram się pokazać, że cesarz jest nagi.

Jen Gennai: „Byliśmy kilkakrotnie wzywani na przesłuchanie przed Kongresem…”. „Mogą nas naciskać, ale my się nie zmienimy”.

Zach Vorhies: Jestem jak mała mrówka, która może zostać z łatwością zgnieciona. Ale to jest coś większego, niż ja, o tym trzeba powiedzieć amerykańskim obywatelom.

Jen Gennai: „Elizabeth Warren twierdzi, że trzeba podzielić Google na mniejsze podmioty. Lubię ją, ale myli się, gdyż to niczego nie poprawi, a wręcz uczyni gorszym. Te małe wydzielone spółki, które nie będą miały dostępu do takich zasobów, jak my będą musiały poradzić sobie i zapobiegnięciu kolejnej „sytuacji z Trumpem”, a taka mała firma nie jest w stanie poradzić sobie z takim zadaniem.

Project Veritas przedstawia.

Bohaterski informator alarmuje w sprawie projektu Google pod nazwą „Maszynowe Uczenie Sprawiedliwości”.

Project Veritas, Jen Gennai z Google i Maszynowe Uczenie Sprawiedliwości

Jeden z dyrektorów ujawnia plan Google mający na celu „zapobieżenie sytuacji z Trumpem” w wyborach w 2020 roku.

James O’Keefe (Project Veritas): Wcześnie w tym roku jeden z pracowników Facebooka ujawnił prowadzone przez platformę działania mające na celu „tłamszenie” aktywności konserwatystów na Facebooku. Pracownik ten zainspirował innego pracownika, tym razem zatrudnionego w Pinterest, by również zgłosił się do nas ze swoją historią. W zeszłym tygodniu upubliczniliśmy raport dostarczony przez Erica Cochrana z Pinterest, w który wskazano na praktyki cenzorowania treści o tematyce chrześcijańskiej i pro-life.

Eric Cochran

Eric Cochran: Firmy z branży technologicznej nie są w stanie wszystkich nas pokonać.

James O’Keefe (Project Veritas): Dzisiejszym naszym gościem będzie pracownik Google, odważny mężczyzna, który zgłosił się do nas z historią, która jest przerażająca.

Zach Vorhies (Informator z google): Uważam, że najlepszym środkiem dezynfekującym jest światło słoneczne i ludzie muszą zacząć zadawać pytania.

James O’Keefe (Project Veritas): Na kilka tygodni przed tym, jak swoją wiedzą z nami podzielił się informator z Google, współpracownik Project Veritas nagrał z ukrycia rozmowę z Jen Gennai, która jest jednym z dyrektorów w Google. Jen Gennai opowiada o tym, jak dokłada się wszelkich starań, by przy wszystkich wyszukiwaniach, poprzez użycie algorytmów uczenia maszynowego, agenda polityczna Google była zawsze uwzględniana w wynikach wyszukiwania.

Jen Gennai: W 2016 r. wszyscy zostaliśmy wykiwani. Znów, nie tylko my, ludzie zostali wykiwani, media zostały wykiwane, wszyscy zostali wykiwani, więc od razu zaczęliśmy się zastanawiać, jak do tego doszło i jak temu zapobiec w przyszłości.

Zach Vorhies (Informator z google): Zaraz po tym, jak Donald Trump wygrał wybory prezydenckie w 2016 r., firma zmieniła kierunek o 180 stopni. Jeśli wcześniej promowano takie wartości jak prawo do samo ekspresji, że każdy głos jest ważny ale teraz mówią, że Sieć jest pełna hejtu, mowy nienawiści, rasizmu, mizoginii i z tego powodu właśnie Donald Trump został prezydentem. Tak więc teraz musimy to naprawić. Musimy zacząć kontrolować naszych użytkowników, ponieważ nie chcemy powtórzyć wyniku z tamtych wyborów.

James O’Keefe: Porozmawiajmy zatem o tej kwestii. Więc… Opowiedz proszę więcej o tym, co zaobserwowałeś na tych zebraniach lub o tym, co się działo po wygranej Trumpa. Kto i co mówił, powiedział.

Zach Vorhies: Otóż to, co uległo zmianie, to że kadra menedżerska zaczęła mówić o potrzebie walki z hejtem i rasizmem w Sieci i na Youtube’ie. Podobne spotkania organizowała także dyrektor Youtube’a Susan (Wojcicki). Mówiono o walce z takimi zjawiskami oraz skończeniem z brakiem bezstronności na tych platformach. Zaczęto wtedy powoli zarysowywać koncepcję „Maszynowego Uczenia Sprawiedliwości”.

James O’Keefe: Jen Gennai jest dyrektorem ds. Odpowiedzialnej Innowacyjność w Międzynarodowym Departamencie Google. Jest ona odpowiedzialna za kreowanie polityki firmy w kontekście zasad etyki odnośnie uczenia maszynowego oraz Sztucznej Inteligencji. Dowiedzieliśmy się, że Wyszukiwarka Google jest w coraz większym stopnia oparta na S.I.

Jen Gennai: Powodem, dla którego wystartowaliśmy z projektem zasad dla S.I. jest to, że ludzie sami nie stworzyli takich jasnych granic. Nie określono, jak mamy rozumieć równość i sprawiedliwość/bezstronność, wiec pomyśleliśmy, że skoro jesteśmy dużą firmą, to my to doprecyzujemy. Moja definicja bezstronności i tendencyjności jest ściśle związana z historycznie marginalizowanymi grupami. Na tym się skupiam. Grupy społeczne u władzy, które tradycyjnie u tej władzy są, to nie jest przedmiot moich działań na rzecz rozwiązania kwestii sprawiedliwości. Nasza definicja bezstronności, jak nam się wydawało, jest czymś oczywistym, czymś, co do czego każdy by się zgodził, ale tak się nie stało.

Osoby takie jak Ci, którzy głosowali na obecnego prezydenta, osoby takie nie zgadzały się z naszą definicją sprawiedliwości.

Zach Vorhies: Bezstronność/uczciwość, to nic innego jak przekaz kierowany do określonej grupy odbiorców. Nie oznacza tego, co Ci się wydaje. Trzeba zastosować „dwójmyślenie Orwellowskie”, aby zrozumieć ten komunikat. To co naprawdę stoi za „bezstronnością” to to, że oni muszą manipulować wynikami wyszukiwania, co pozwoli im realizować ich agendę polityczną. Dlatego też muszą skorygować preferencje swoich algorytmów tak, by móc dotrzeć ze swoją agendą do użytkowników. Jeśli odkodujesz to, co ona mówi, o tym, że chce by, że jej celem jest zmodyfikowanie algorytmu tak, aby był „bezstronny/uczciwy” względem starannie wybranych przedstawicieli określonych grup społecznych. Ona ma na myśli przez to, że jej celem jest sprzedać Wam produkt, który nie podlega sprzeciwowi. Jej zależy na tym, by sprzedać Wam produkt, który nie jest obiektywny, nie jest reprezentatywny dla użytkowników tego produktu lecz woli grupy osób ukrytej w cieniu, która podejmuje decyzje.

James O’Keefe: Czego dowiedziałeś się będąc w Google, związanego z całą to ideą „bezstronności”?

Zach Vorhies: Pracując w Google, z rzeczy związanych z koncepcją „bezstronności” natrafiłem na algorytm uczenia maszynowego nazwany „Machine Learning Fairness”, gdzie skrót ML oznacza „uczenie maszynowe”, a „sprawiedliwość” oznacza cokolwiek co oni zdefiniują jako sprawiedliwe czy bezstronne.

„Bezstronność” w tym przypadku należy rozumieć jako „brak bezstronności”, ponieważ jako dane wejściowe bierze się „kliknięcia” wykonywane przez użytkowników i na tej podstawie algorytm wnioskuje, jakie sygnały te kliknięcia generują oraz jakie sygnały należy wzmocnić, a jakie wyrzucić.

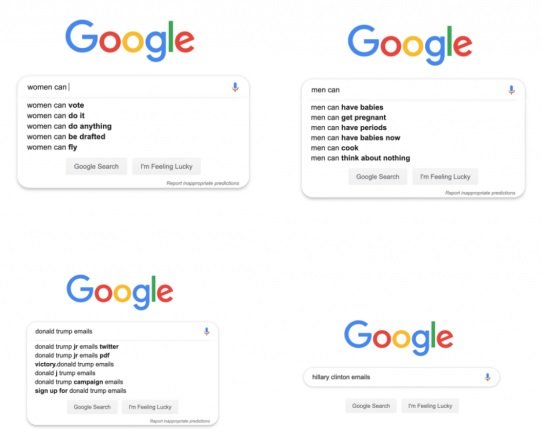

James O’Keefe: Mam przed sobą Wyszukiwarkę Google uruchomioną w przeglądarce. Przeprowadzimy teraz mały test tej sztucznej inteligencji [S.I.] opartej na uczeniu maszynowym. Wprowadzę teraz następujące słowa: Mężczyzna, potrafi/może. Pojawiają się podpowiedzi takie jak: „mężczyzna może mieć dzieci”, „mężczyzna może zajść w ciąże”, „mężczyzna może mieć okres”, „mężczyzna potrafi gotować”.

Ludzie wyszukują takie rzeczy? Czy Google wpływa na te wyniki?

Zach Vorhies: Ludzie nie wyszukują tych fraz. Te wyniki pochodzą prosto z autorytatywnych baz danych, które zostały arbitralnie wybrane jako źródło prawdy i z tych baz pobierane są te wyniki.

James O’Keefe: Spróbujmy ponownie, tym razem wpisując słowa „kobiety” i „potrafią/mogą”. Nie widzę… Pojawiają się wyniki „kobiety mogą głosować”, „kobiety potrafią”, „kobiety są w stanie zrobić wszystko”, „kobiety mogą się zaciągnąć do wojska”.

Zach Vorhies: Tak

James O’Keefe: To trochę zaskakujące. Wszystkie te przykłady są częścią narracji związanej ze Sprawiedliwością Społeczną. Zgadza się?

Zach Vorhies: Autorytatywne źródła wiedzy, z których „Maszynowe Uczenie Sprawiedliwości” czerpie w celu wzmocnienia uczenia się, to właśnie te słowa kluczowe. Ponieważ te autorytatywne źródła komunikatów zostały „zwandalizowane”, dane wyjściowe wygenerowane przez algorytm odzwierciedlają tę „wandalizację/barbaryzację”.

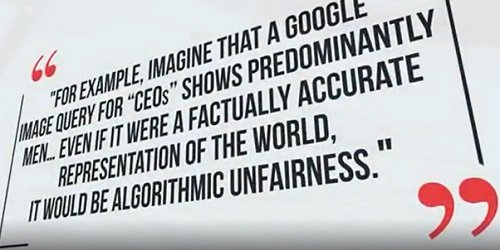

James O’Keefe: Redakcja Project Veritas weszła także w posiadanie masy dokumentów wewnętrznych Google Prezentowany dokument dotyczy tzw. „problemu tendencyjności algorytmów”. Tu cytat:

„Dla przykładu, wyobraźmy sobie, że wprowadzamy w Wyszukiwarce Google dla obrazów frazę ‘CEOs’ dyrektorów generalnych, gdzie wyświetla się nieproporcjonalnie więcej obrazów przedstawiających mężczyzn. Nawet jeśli dokładnie odwzorowuje to stan faktyczny, byłby to przykład ‘tendencyjności algorytmu’.”

Koniec cytatu.

Gaurav Gite, inżynier oprogramowania w Google, niezależnie potwierdził tezę zawartą w tym dokumencie.

Gaurav Gite: Jednakże mamy też takie zagadnienia jak Maszynowe Uczenie Sprawiedliwości.

Dziennikarka: ML fairness?

Gaurav Gite: Uczciwość. Rozumiesz, konieczność bycia uczciwym, bezstronnym.

Dziennikarka: A, Maszynowe Uczenie Sprawiedliwości, ok.

Gaurav Gite: Więc podąża się w kierunku takiego zmodyfikowania modelu w taki sposób, że nawet jeśli kobiety na stanowiskach CEO (dyrektor generalny) jest statystycznie

Dziennikarka: Mniej, liczbowo.

Gaurav Gite: Tak, mniej.

Dziennikarka: Czyli model bilansuje wyniki wyszukiwania?

Gaurav Gite: Tak, koryguje je.

James O’Keefe: To jest dokument poufny, zgadza się?

Zach Vorhies: Tak

James O’Keefe: Google nie przyznaje się, że jest to jeden z dokumentów wewnętrznych pokazujący ich procedury.

Zach Vorhies: Zgadza się.

James O’Keefe: W dokumencie tym możemy przeczytać, może przeczytam fragment…

Zach Vorhies: Co więcej, jeśli zaczniesz powoływać się na niego i resztę dokumentów oni powiedzą, że to jest teoria spiskowa.

James O’Keefe: O rany. Czyli nie przyznają się do tego publicznie?

Zach Vorhies: Nigdy publicznie nie potwierdzą tych dokumentów.

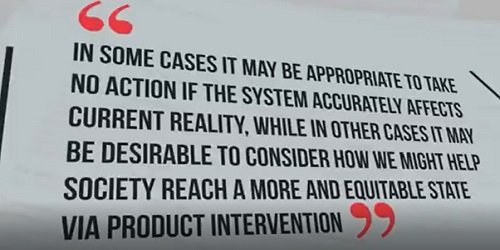

James O’Keefe: W dokumencie tym czytamy:

„W niektórych przypadkach najodpowiedniejszym ruchem może być niepodejmowanie żadnych działań, jeśli system właściwie/odpowiednio wpływa na obecną rzeczywistość, podczas gdy w innych przypadkach wartym rozważenia może być kwestia w jaki sposób można pomóc społeczeństwu osiągnąć bardziej sprawiedliwy i słuszny stan poprzez możliwą ingerencję w produkt”.

James O’Keefe: Co należy przez to rozumieć?

Zach Vorhies: Więc… Próbują stać się samozwańczym moderatorem, który reguluje dostęp do treści wyszukiwanych przez użytkowników. Tym sposobem będą filtrować treści i decydować wedle uznania, które treści będą i nie będą udostępniane użytkownikom, w celu ograniczenia niepożądanych dla nich wyników.

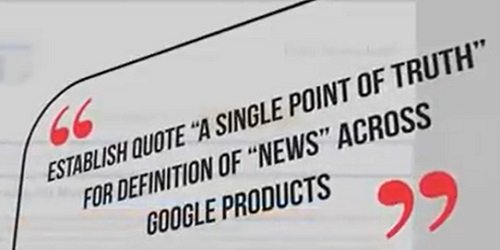

James O’Keefe: Ten dokument ma status „Wyłącznie do użytku wewnętrznego Google”, jego treść dotyczy planu, którego celem jest cytat:

„ustanowienie ‘autorytatywnego i scentralizowanego źródła danych’ odnośnie definicji ‘komunikatów informacyjnych’ dla wszystkich produktów Google”.

Koniec cytatu.

Co to znaczny?

Zach Vorhies: Kiedy używają sformułowania „autorytatywnego i scentralizowanego źródła prawdy” mają na myśli zgodność z ich narracją. Narracja ta jest kreowana przez graczy z establishmentu. Ich celem jest wzmocnienie cyrkulacji treści dobieranych autorytatywnie.

Jen Gennai: Oskarżano nas od brak bezstronności odnośnie treści o charakterze konserwatywnym, ponieważ dobieramy źródła informacji, które definiujemy jako wiarygodne i źródła te niekoniecznie pokrywają się ze źródłami konserwatywnymi więc padają z tej strony oskarżenia o brak bezstronności”.

James O’Keefe: Czy Google posiada wytyczne redakcyjne? Czy firma na którymś etapie podejmuje decyzje odnośnie udostępnianych wiadomości informacyjnych? To właśnie widzimy w tym dokumencie?

Zach Vorhies: Tak. To jest schemat opisujący proces zarządzania informacjami w Google News.

James O’Keefe: Czy Google miałoby problem, gdyby opinia publiczna ujrzała ten dokument?

Zach Vorhies: Tak sądzę.

James O’Keefe: Dlaczego Google nie chce, aby ludzie ujrzeli ten dokument?

Zach Vorhies: Powód jest taki, że w tym tutaj miejscu w niektórych z etapów opisanych w blokach ingeruje się w proces doboru treści, redaguje się sposób publikacji treści zgodnie w wytycznym ich agendy. Jeśli spojrzeć na szerszy kontekst, to okaże się, że jest tam wpleciony system „Maszynowego Uczenia Sprawiedliwości” na etapie weryfikacji algorytmicznej. Tutaj twierdzą, że jest to stosowane w oceny indeksowania stron i dostępności treści, ale w rzeczywistości na to ma celu selekcję treści zgodną z ich agendą. Jeśli jest zgodne, przechodzi dalej, jeśli nie, to nie ujrzy światła dziennego.

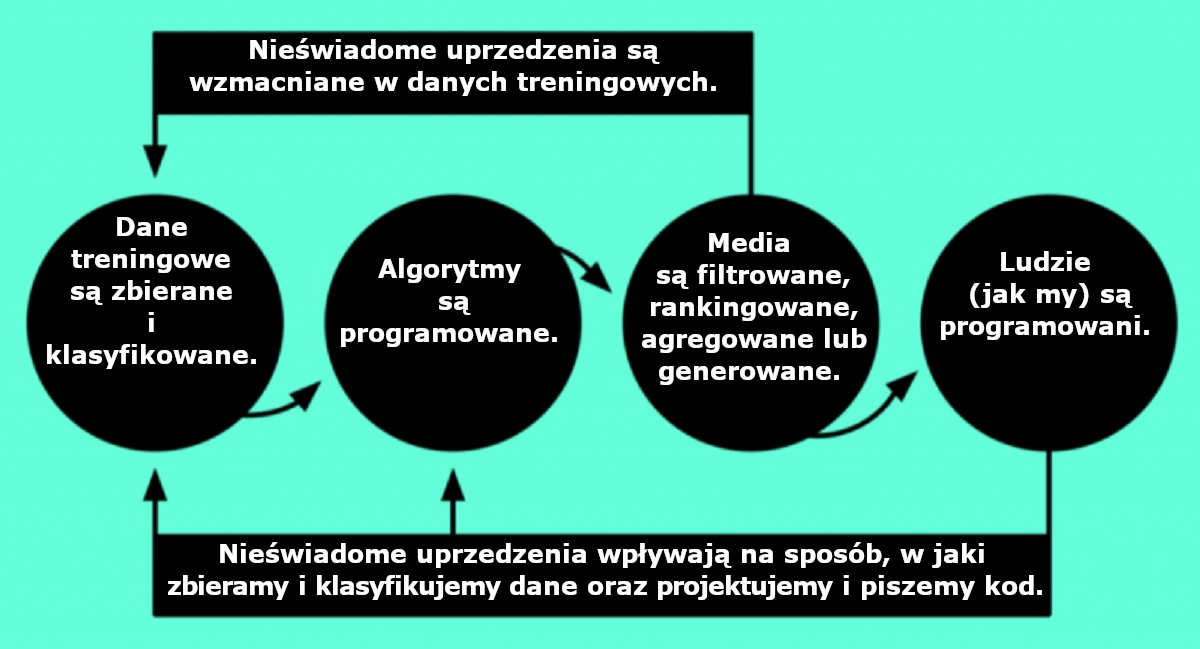

James O’Keefe: Inne z pozyskanych dokumentów wewnętrznych Google opisują nadzieję pokładaną w „Maszynowym Uczeniu Sprawiedliwości”.

Dane treningowe są zbierane i klasyfikowane.

Algorytmy są programowane.

Media są filtrowane, rankingowane, agregowane lub generowane.

Ludzie (jak my) są programowani.

To wygląda na inżynierię społeczną, a nie wyszukiwanie zapytań.

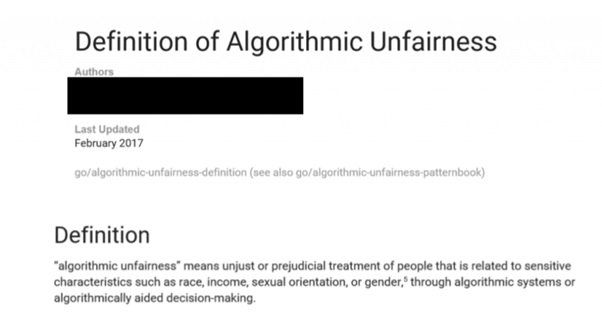

Definicja „tendencyjności algorytmu”.

Potęga Google stała się problemem politycznym. Politycy obu stron debatują nad tym, czy nie należy zastosować ustawy antytrustowej lub innych stosownych środków prawnych.

Jen Gennai: Byliśmy wielokrotnie wzywani przed Kongres, ale nie stawialiśmy się bo wiemy, że będą nas tylko atakować. Nie zmienimy, nie zmienimy naszego zdania. Nie ma sensu siedzieć tam i być atakowanym w sprawie, w której i tak nie zmienimy zdania. Mogą nas naciskać, ale my się nie zmienimy. Jednocześnie musimy być świadomi, jaki jest ich cel i o co nas oskarżają. Jak mówiłam, mogą tylko… Elizabeth Warren, uwielbiam ją, ale ona także głosi, że wystarczy podzielić Google i to rozwiąże problem. Elizabeth Warren twierdzi, że trzeba podzielić Google na mniejsze podmioty. Uwielbiam ją, ale myli się, gdyż to niczego nie poprawi, a wręcz uczyni gorszym. Te małe wydzielone spółki, które nie będą miały dostępu do takich zasobów jak my, będą musiały poradzić sobie z 'sytuacją z Trumpem’, a taka mała firma nie jest w stanie poradzić sobie z takim zadaniem. Biały Dom i Kongres nie odegrają żadnej roli w uczynieniu sytuacji bardziej sprawiedliwą, więc ludzie liczy na nas, że zapełnimy tę lukę jak należy.

James O’Keefe: Obecnie w Waszyngtonie toczy się gorąca dyskusja, mówi się o ustawach antytrustowych, o ew. rozwiązaniach prawnych odnośnie podziału Google. Jak Twoi szefowie czy współpracownicy w Google reagują na tę sytuację?

Zach Vorhies: W dużej mierze to ignorują, dla nich ten temat wręcz nie istnieje. Nie postrzegają tego jako realne zagrożenie – już raz miała miejsce taka sytuacja i nic z tego nie wyszło. Ona powiedziała to, co Google naprawdę myśli. Czego nie powiedzą publicznie. Ona powiedziała to, co bardzo wielu z nas dostrzega i wie, że jak jest naprawdę. Przyłapaliście ją na mówieniu prawdy. Oni nie są obiektywnym medium, nie są obiektywnym źródłem informacji. Jest to bardzo stronnicza machina polityczna zaangażowaną w niedopuszczenie osób takich jak Donald Trump ponownie do władzy.

Jen Gennai: Na 2020 rok, na pewno najlepsi ludzie z mojej dawnej organizacji, Trust and Safety, już od 2016 r. pracują intensywnie, byśmy byli w pełni gotowi na 2020 rok. Uczymy również nasze algorytmy na ewentualność powtórki z 2016 r. testując, czy wynik byłby inny?

James O’Keefe: Nie jest do końca jasne, do czego dokładnie odnosi się Jen Gennai ale polityczna agenda Google jest oczywista.

Jakie jeszcze frazy mogę wpisać?

Zach Vorhies: „Emaile Hillary Clinton są”. Nie wyskakują żadne autouzupełniania.

James O’Keefe: Google tym samym sugeruje, że ludzie nie wyszukują tych fraz? Zgadza się?

Zach Vorhies: Tak właśnie. Sugerują, że nie warto nawet podawać żadnych wyników wyszukiwania.

James O’Keefe: Ale przecież ludzie wyszukują te frazy.

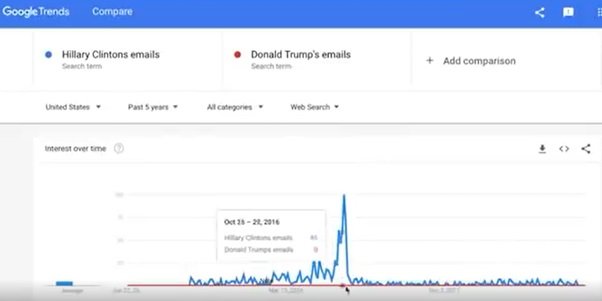

Zach Vorhies: Oczywiście. I łatwo to pokazać analizując wzajemne odniesienia do treści udostępnianych w ramach innych usług Google. Podam może przykład. Udaj się proszę pod adres trends.google.com.

James O’Keefe: Ok, już to robię. Trends, kropka, google, kropka, com Ok, co mam wpisać?

Zach Vorhies: „Emaile Hillary Clinton”. Ok. Teraz ustaw zakres czasowy na „Ostanie 5 lat”.

James O’Keefe: Wygląda na to, że szczyt przypada na październik 2016 r. Wierzchołek jest na poziomie 100. To 100 oznacza…

Zach Vorhies: To jest skala względna. Ten wynik trzeba porównać z inną wyszukiwaną frazą, by otrzymać obraz relatywnej popularności tej frazy.

James O’Keefe: Ok, wpiszmy „Emaile Donalda Trumpa”. Co tutaj widzimy, wyjaśnij proszę?

Zach Vorhies: Otóż, widzimy tutaj, że względem frazy „Emaile Hillary Clinton”, fraza „Emaile Donalda Trumpa” nie generuje żadnego ruchu.

James O’Keefe: Brak [ruchu] wyszukiwań. Teraz powróćmy do Wyszukiwarki Google i wpiszmy frazę „Emaile Donalda Trumpa”. Nie powinny nam się pojawić żadne sugestie w autouzupełnianiu, gdyż jak twierdzi Google, nikt takiej frazy nie wyszukuje w porównaniu z podobną frazą „Emaile Hillary Clinton”. A jednak nie. Wyskakuje wiele różnych przykładów autouzupełniania.. Nikt czy mniejsza liczba osób wyszykuje tę frazę, ale funkcja autouzupełniania podpowiada dalsze frazy. Wszyscy wyszukują frazy „Emaile Hillary Clinton”, ale funkcja autouzupełniania nie wyświetla podpowiedzi.

Zach Vorhies: Zgadza się.

James O’Keefe: Jak to wyjaśnić?

Zach Vorhies: Cóż, według nich, afera z emailami Hillary Clinton to teoria spiskowa i nieuczciwym byłoby wyrzucać wyniki wyszukiwania na podstawie tej frazy. Stosując swój program „Maszynowego Uczenia Sprawiedliwości”, usunęli podpowiedzi autouzupełniania z Sieci tak, jakby nigdy nie istniały.

James O’Keefe: Jak tego dokonano? Ręcznie, ludzką interwencją, maszynowo? S.I?

Zach Vorhies: To działa tak, że teraz uczą swoją sztuczną inteligencję [S.I.] na podstawie działań pewnej grupy osób, którzy uważają się za wojowników o sprawiedliwość społeczną [SJW], czy jak tam ich nazwać, te wszystkie informacje są przetwarzane przez S.I. w celach treningowych, by nauczyć model, by generował właśnie takie [pożądane] rezultaty. Kiedy jednak trening nie kończy się powodzeniem, dedykowana osoba ręcznie usuwa określone słowa kluczowe albo umieszcza je na czarnej liście. Mnóstwo osób wewnątrz Google zgłasza błędy związane z wyszukiwaniem, ale są one ignorowane, ponieważ oni nie mają interesu w adresowaniu problemów, które stoją w sprzeczności z ich narracją opartej na Sprawiedliwości Społecznej lub nie spełniają ich definicji bezstronności.

James O’Keefe: Google jest prawnie chroniony zgodnie z artykułem 230 Ustawy o Przyzwoitości w Środkach Przekazu. Przepis ten stanowi, tu cytat:

„Żaden dostawca bądź użytkownik usługi interaktywnej dostępnej za pomocą komputera nie może być traktowany jako faktyczny podmiot publikujący lub głoszący treści dostarczane przez dostawców tych treści”.

Koniec cytatu.

Oznacza to, że Google nie jest prawnie odpowiedzialny za jakiekolwiek treści na ich platformie Niektórzy uważają, że rozwiązaniem byłoby usunięcie art. 230 z tej ustawy.

Zach Vorhies: Google narusza nie tylko literę tego prawa, lecz również jego ducha. Art. 230 mówi tyle, że jeśli Google ma działać na zasadzie platformy, nie może cenzorować treści swoim użytkownikom. Google postanowił funkcjonować jako wydawca, czyniąc ich odpowiedzialnymi za wszelki treści, które umieszczają. Google wciąż przedstawią się jako platforma, choć ich działania mają charakter wydawniczy. Ale na Wyszukiwarce Google sprawa się nie kończy.

James O’Keefe: Nasz informator podzielił się z nami wiedzą, że z cenzurą polityczną mamy również do czynienia na YouTubie, którego właścicielem jest Google. Powiedział nam, że spotkanie wyjazdowe YouTube odbyło się w dosyć dziwnym miejscu.

Zach Vorhies: To było wydarzenie, które miało miejsce w maju tego roku. Zaproszono nas wszystkich do (…) na dyskusję o przyszłości firmy YouTube. Powiedziano nam, że wprowadzone zostaną nowe mechanizmy filtracji treści. Niedługo po tym wielu twórców na YouTubie zaczęło masowo tracić wpływy z reklam (tzw. demonetyzacja), ich materiały zaczęły spadać w rankingach, mam tu na myśli takie osoby i profile ja Dave Rubin, Carpe Diem, czy Tim Pool. Także wielu innych twórców treści działających w społeczności YouTube’a zaczęło obserwować gwałtowne spadki oglądalności ze strony użytkowników.

James O’Keefe: Co takiego YouTube zrobił, że odnotowano spadki liczby wyświetleń?

Zach Vorhies: Google celuje w użytkowników, których określa jak prawicowych komentatorów politycznych, wliczając w to Tima Poola, Dave’a Rubina, czy Stevena Cartera oraz szereg innych prawicowców komentatorów, których opinii Google nie życzy sobie rozprzestrzeniać. Więc ingerują w treści, do których użytkownicy mogą uzyskać dostęp. Google może brać na celownik takie osoby poprzez zastosowanie S.I. do transliteracji treści materiałów wideo. [Transliteracja – konwersja słów na tekst pisany] Analizują przełożony tekst pod kątem treści i odpowiednio klasyfikują używając określonych kategorii, jak „prawicowiec”, „wiadomości – niusy”, etc., po czym te dane są przetwarzane przez ich algorytmy „bezstronności” w celu „sprawiedliwego” zdjęcia tych treści z platformy.

James O’Keefe: Nasz informator potwierdził, że PragerU, konserwatywny kanał edukacyjny na YouTube oraz kanał wideo Dave’a Rubina zostały zanalizowane przy użyciu narzędzia analitycznego Viacon, opartego na sztucznej inteligencji [S.I.]. Viacon, który jest używany jest do kontrolowania materiałów na YouTube, zaklasyfikował kanały Prager oraz Dave’a Rubina jako „prawicowe” oraz „pogadanki o nowościach”.

Zach Vorhies: Są poza jakąkolwiek kontrolą.

James O’Keefe: Co jest w tym wszystkim dla Ciebie przerażające?

Zach Vorhies: Przerażające jest to, że to Google decyduje, co jest ważne, a co nie. Oni praktycznie eliminują jakąkolwiek debatę z narodowej przestrzeni publicznej. To wszystko przypomina mi książkę pt. „1984”. To powinno być dla nas wszystkich ostrzeżeniem. Ta książka nie jest dobrą instrukcją, jak kierować społeczeństwem. A Google właśnie wpada w tę pułapkę. Decydują o tym, co będzie czytane, co będzie konsumowane, co ludzie mogą klikać. Wiecie… To mi bardzo przypomina totalitaryzm [nazizm]. To nie tylko chodzi o palenie książek, Jeśli mamy do czynienia z usuwaniem materiałów wideo z platformy, to jest to też forma cenzury. Pracowałem w Google przez dobrych kilka lat, więc wiem, o czym mówię. Dla wielu ludzi to jest szokujące, ale dla mnie… Dlatego też postanowiłem ujawnić, co wiem. Bo to jest szokujące. A ludzie nie mają pojęcia, że to się dzieje naprawdę. Wciąż myślą, że Google to obiektywne źródło informacji, ale tak nie jest.

James O’Keefe: Boisz się?

Zach Vorhies: Boję się, ale bałem się bardziej, gdy zastanawiałem się, co się stanie z moją żoną w wyniku całej tej sytuacji, ale teraz… Pomyślałem, jak wyglądałby taki świat i nie było to miejsce, w którym chciałbym żyć.

James O’Keefe: Co się teraz z Tobą stanie?

Zach Vorhies: Mam nadzieję, że mi się upiecze i krzywda mi się nie stanie, ale… Różne wypadki się zdarzają. Jak mówiłem, oni są jak Behemot, Goliat, a ja jestem tylko Dawidem, który stara się pokazać, że cesarz jest nagi. Jestem jak mała mrówka, która może zostać z łatwością zgnieciona. Ale to jest coś większego, niż ja, o tym trzeba powiedzieć amerykańskim obywatelom.

James O’Keefe: W tym roku kilkoro informatorów zgłosiło się do Project Veritas i opowiedziało nam swoje historie, ujawniając działania gigantów z Doliny Krzemowej. Ich odwaga oraz bohaterstwo pokazują, że firmy z brany Big Tech nie są bezkarne. To jest punkt zwrotny. To nie New York Times czy CBS News wykonują tą pracę. To indywidualni obywatele i obywatelki, anonimowi bohaterowie, którzy ryzykują swoją karierą. Którzy podjęli ważki, lecz niewygodny temat i postanowili podzielić się tym z Wami poprzez Project Veritas. Ludzie często mnie pytają: „Co ja mogę zrobić?” Podążaj śladami Erica Cochrana i informatora z Google. Ty też możesz zostać bohaterem, bierz do ręki kamerę i skontaktuj się z nami za pomocą bezpiecznego kanału pod adresem www.projectveritas.com/brave.

Insider Blows Whistle & Exec Reveals Google Plan to Prevent “Trump situation” in 2020 on Hidden Cam

Project Veritas, Jen Gennai z Google i Maszynowe Uczenie Sprawiedliwości – napisy PL